Automatisierte Videoarchivierung durch LLM und Video-KI

Die Herausforderung

Unser Kunde, das Deutsche Rundfunkarchiv (DRA), möchte die im Archiv vorhandenen Videos automatisiert erfassen und analysieren. Dabei steht die Vor- und Abspannerkennung im Fokus.

Ziel des Projekts war alle im Vor- und Abspann ablaufenden Text-Inhalte durch Video-KI und OCR automatisiert zu erkennen und mithilfe eines Large-Language-Modells in ein vorbestimmtes Standardformat zu überführen.

Die Herausforderungen:

- Jedes Video ist anders, bei tausenden Videos kann man nur stichprobenartig testen und weiß nie was auf einen zukommt

- Viele Edge-Cases

- Hoher Datenschutzanspruch

- OCR-Algorithmen sind kaum auf altdeutsche Schriftbilder trainiert, die bei diesen sehr alten Videos noch oft vorkommen

- Kombination aus lokalem Rechenzentrum und Hyperscaler-Cloud-Produkten

Unser Projektweg

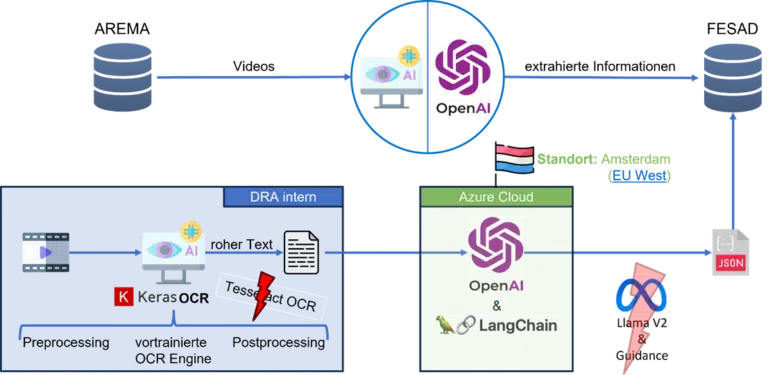

Durch die Mischung aus Datenschutz-Voraussetzungen, schwierigen Voraussetzungen für OCR und keiner Möglichkeit die Videos mit Cloud Produkten auszulesen, haben wir verschiedenste Architekturen und Szenarien konzipiert, wie das System aufgebaut werden kann.

Tooling

Unser Tooling hat sich konstant weiterentwickelt, um sich an die Anforderungen des Projektes anzupassen. In der finalen Version haben wir mit KerasOCR (Pre- sowie Postprocessing), OpenAI on Azure, LangChain, JSON sowie selbst entwickelten Python Schnittstellen und einer Anbindung an On-Prem Server gearbeitet.

Projekt-Ergebnisse

In der ersten Projektphase konnten wir eine hohe Erkennungsquote der Vor- und Abspänne ermöglichen. Die Schwachstelle des Systems war, dass die OCR-Algorithmen nicht präzise genug mit altdeutschen Schriftbildern umgingen. Gleichzeitig ist es nicht leicht den generierten Text einer generativen KI auf ein festes Schema zu beschränken. Nach Abschluss der ersten Projekt-Phase konnten wir 80-90% (je nach Bewertungsansatz) der Videos automatisiert korrekt erkennen. Das Zwischenfazit war hier also, dass es ein nützliches Assistenzsystem ist, man jedoch noch nicht voll automatisiert alle Videos ohne menschliches Zutun analysieren kann. Hier setzt nun eine zweite Projektphase an, um die OCR zu verbessern und die Ergebnisse präziser zu gestalten.

Business Value

- Befüllte Vorlagen zur Archivierung des Videos

- Bei fehlgeschlagenen Analysen meist direkt ersichtlich, dass die OCR nicht gut genug war

- Schnellere Archivierung durch Assistenzsystem möglich

- In einer zweiten Projektphase wird die OCR mit dem Ziel verbessert, die Videos ohne menschliches Zutun archivieren zu können und neue Funktionen ergänzt

Das Projektvorgehen

-

#1 Potenzial erkennen

Wir lernen uns kennen und Ailio erstellt eine kostenlose Potenzialanalyse. -

#2 Workshop

Gemeinsam definieren wir ein in 1-3 Monaten lieferbares Leuchtturmprojekt mit hohem Business Value. -

#3 Data Sprint

Ailio analysiert Ihre Datenbasis und baut mit geringem Aufwand ein erstes Proof of Concept. -

#4 MVP

Nach erfolgreichem Data-Sprint bringen wir den Use Case auf die Straße. -

#5 Full Release

Gemeinsam optimieren wir die Erfolgsmetriken und Rollen unsere Lösung unternehmensweit aus.